- Принцип сканирования роботом

- Создание поискового файла

- Оптимизация страниц

- Технический синтаксис

- Сопоставления шаблонов

- Проверка наличия робото-файла

- Оптимизация SEO

- Поисковые системы

- Запрет страниц

- Настройка стандартов

- Советы по повышению производительности сервера

- Установка задержки сканирования

- Лучший бот WordPress

- Основная настройка Joomla

- Робот в облаке MODX

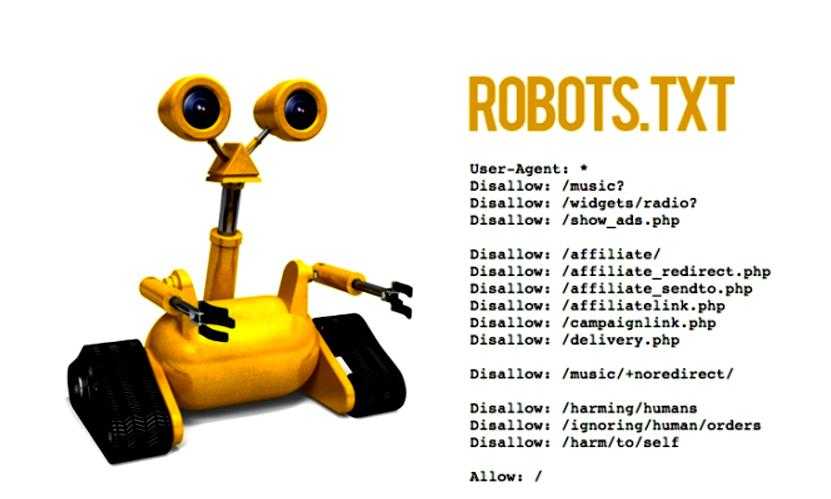

Правильный Robots txt для html сайта создает макеты действия для ботов поисковых систем, сообщая им, что они могут проверять. Часто этот файл упоминается, как Протокол исключения роботов. Первое, что ищут боты перед сканированием веб-сайта, - robots.txt. Он может указывать на Sitemap или сообщать ему, чтобы он не проверял определенные поддомены. Когда нужно, чтобы поисковики искали то, что наиболее часто встречается, то robots.txt не требуется. Очень важно в этом процессе, чтобы файл был отформатирован грамотно и не индексировал пользовательскую страницу с личными данными пользователя.

Принцип сканирования роботом

Вам будет интересно:Как настроить Robots.txt правильно?

Вам будет интересно:Как настроить Robots.txt правильно?

Когда поисковая система встречает файл и видит запрещенный URL адрес, она не сканирует его, но при этом может проиндексировать его. Это связано с тем, что даже, если роботам не разрешено просматривать содержимое, они могут запоминать обратные ссылки, указывающие на запрещенный URL адрес. Из-за заблокированного доступа к ссылке URL адрес появится в поисковиках, но без фрагментов. Если для входящей маркетинговой стратегии требуется правильный Robots txt для bitrix (битрикс) , обеспечивают проверку сайта по желанию пользователя сканерами.

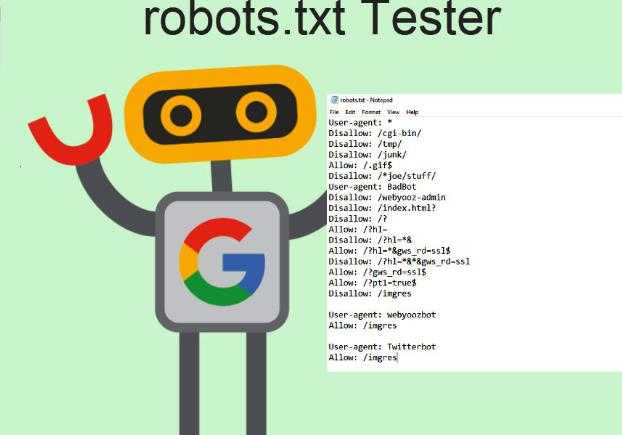

С другой стороны, если файл некорректно отформатирован, это может привести к тому, что сайт не будет показан в результатах поиска и его не найдут. Этот файл поисковики обойти не могут. Программист может посмотреть robots.txt любого сайта, перейдя в его домен и, следуя за ним с помощью robots.txt, например, www.domain.com/robots.txt. Используя такой инструмент, как раздел оптимизации SEO Unamo, в котором можно ввести любой домен, и сервис покажет информацию о наличии файла.

Ограничения для сканирования:

Вам будет интересно:Мета-тег Title: назначение, правильная запись, заполнение, проверка и рекомендации

Вам будет интересно:Мета-тег Title: назначение, правильная запись, заполнение, проверка и рекомендации

Нужно иметь в виду, что информация, которую пользователь желает получить от поисковика, доступна для всех, кто вводит URL. Не стоит использовать этот текстовый файл для сокрытия конфиденциальных данных. Если домен имеет ошибку 404 (не найден) или 410 (прошло), поисковик проверяет сайт, несмотря на наличие robots.txt, в этом случае он считает, что файл отсутствует. Другие ошибки, такие как 500 (Internal Server Error), 403 (Forbidden), тайм-аут или «недоступный», учитывают инструкции robots.txt, однако обход может быть отложен до тех пор, пока файл не будет доступен.

Создание поискового файла

Многие программы CMS, такие, как WordPress, уже обладают файлом robots.txt. Перед тем, как правильно настроить Robots txt WordPress, пользователю необходимо ознакомиться с его возможностями, чтобы выяснить, как получить к нему доступ. Если программист самостоятельно создает файл, он должен соответствовать следующим условиям:

Когда пользователь не знает, где его разместить, он обращается к поставщику программного обеспечения веб-сервера, чтобы узнать, как получить доступ к корню домена или перейти в Google консоле и загрузить его. С помощью этой функции Google также можно проверить, правильно ли бот функционирует, и перечень сайтов, которые были заблокированы с использованием файла.

Основной формат правильного Robots txt для bitrix (Битрикс):

Вам будет интересно:Название для сайта: выбор, тематика , правильное сочетание, оригинальные и популярные названия, советы и примеры

Вам будет интересно:Название для сайта: выбор, тематика , правильное сочетание, оригинальные и популярные названия, советы и примеры

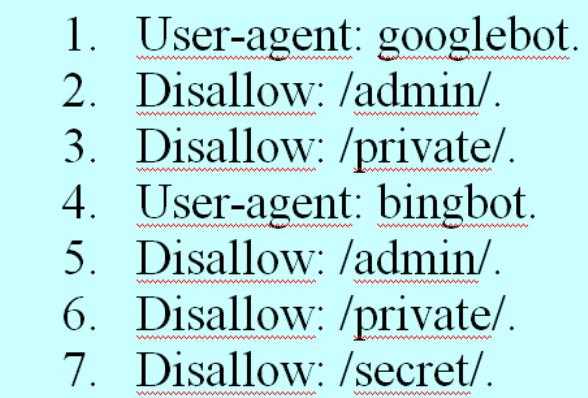

Указание конкретного бота, к примеру, Googlebot, Baiduspider, Applebot. Disallow, указывает сканерам, какие части веб-сайта не нужно сканировать. Это выглядит так: User-agent: *. Звездочка означает «все боты». Однако можно указать страницы для определенных ботов. Для этого нужно знать имя бота, для которого устанавливаются рекомендации.

Правильный robots txt для Яндекса может выглядеть так:

Если бот не должен обходить сайт, можно указать его, а чтобы найти имена агентов пользователя, рекомендуется ознакомиться с онлайн возможностями useragentstring.com.

Оптимизация страниц

Две нижеперечисленные строки считаются полным файлом robots.txt, при этом один файл роботов может содержать несколько строк пользовательских агентов и директив, которые запрещают или позволяют сканирование. Основной формат правильного Robots txt:

В файле каждый блок директив отображается как дискретный, разделенный строчкой. В файле рядом с директорией пользователя агента каждое правило используется применительно к конкретному набору разделенных разделом строк. Если файл имеет правило, действующее для нескольких агентов, робот будет учитывать только наиболее конкретную группу инструкций.

Технический синтаксис

Его можно рассматривать, как «язык» файлов robots.txt. Имеется пять терминов, которые могут существовать в этом формате, основные включают:

Сопоставления шаблонов

Когда дело доходит до фактических URL блокировок или разрешений правильного Robots txt, операции могут быть довольно сложными, поскольку они позволяют использовать сопоставление шаблонов для охвата ряда возможных параметров URL. Google и Bing оба используют два символа, которые идентифицируют страницы или подпапки, которые SEO хочет исключить. Этими двумя символами являются звездочка (*) и знак доллара ($), где: * - это подстановочный знак, который представляет любую последовательность символов. $ - соответствует концу URL-адреса.

Google предлагает большой список возможного синтаксиса задания шаблонов, которые разъясняют пользователю, как правильно настроить файл Robots txt. Некоторые распространенные случаи использования включают:

Проверка наличия робото-файла

Если на сайте нет зон, которые нужно сканировать, то robots.txt вообще не понадобится. Если пользователь не уверен, что есть этот файл, ему необходимо ввести корневой домен и набрать его в конец URL, примерно так: moz.com/robots.txt. Ряд поисковых ботов игнорируют эти файлы. Однако, как правило, эти сканеры не принадлежат к авторитетным поисковикам. Они из рода спамеров, почтовых агрегатов и других типов автоматизированных ботов, которые в большом количестве размещены в Интернете.

Вам будет интересно:Как увеличить просмотры на "Ютубе" до 100000: все действенные способы

Вам будет интересно:Как увеличить просмотры на "Ютубе" до 100000: все действенные способы

Очень важно помнить, что использование стандарта исключения роботов не является эффективной мерой безопасности. Фактически некоторые боты могут начинаться со страниц, на которых пользователь задает им режим сканирования. Есть несколько частей, которые входят в стандартный файл исключения. Прежде чем рассказать роботу, на каких страницах он не должен работать, нужно указать, с каким роботом разговаривать. В большинстве случаев пользователь будет использовать простую декларацию, которая означает «все боты».

Оптимизация SEO

Перед оптимизацией пользователь должен убедиться, что не блокирует какой-либо контент или разделы сайта, которые нужно обойти. Ссылки на страницы, заблокированные правильным Robots txt, не будут соблюдены. Это означает:

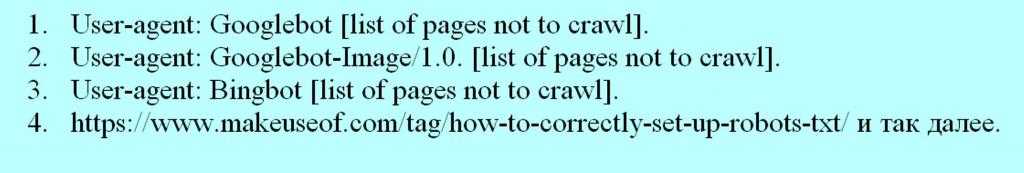

Поскольку другие страницы могут напрямую ссылаться на страницу, содержащую личную информацию и нужно заблокировать эту страницу из результатов поиска, используют другой метод, например, защиту паролем или мета данные noindex. Некоторые поисковые системы имеют несколько пользовательских агентов. Например, Google использует Googlebot для обычного поиска и Googlebot-Image для поиска изображений.

Большинство пользовательских агентов из одной и той же поисковой системы следуют тем же правилам, поэтому нет необходимости указывать директивы для каждого из нескольких поисковых роботов, но, имея возможность сделать это, можно точно настроить сканирование содержимого сайта. Поисковая система кэширует содержимое файла и обычно обновляет содержимое кеширования не реже одного раза в день. Если пользователь изменит файл и хочет обновить его быстрее, чем это происходит стандартно, он может отправить URL robots.txt в Google.

Поисковые системы

Чтобы понять, как работает Robots txt правильно, нужно знать о возможностях поисковых систем. Коротко, их возможности заключаются в том, что они отправляют «сканеры», которые представляют собой программы, просматривающие Интернет для получения информации. Затем они хранят часть этой информации, чтобы впоследствии передать ее пользователю.

Для многих людей Google - это уже Интернет. По сути, они правы, поскольку это, возможно, самое важное его изобретение. И хотя поисковые системы сильно изменились с момента создания, основополагающие принципы их все те же. Сканеры, также известные как «боты» или «пауки», находят страницы с миллиардов веб-сайтов. Поисковые системы дают им указания о том, куда идти, при этом отдельные сайты также могут общаться с ботами и сообщать им, на каких конкретных страницах они должны смотреть.

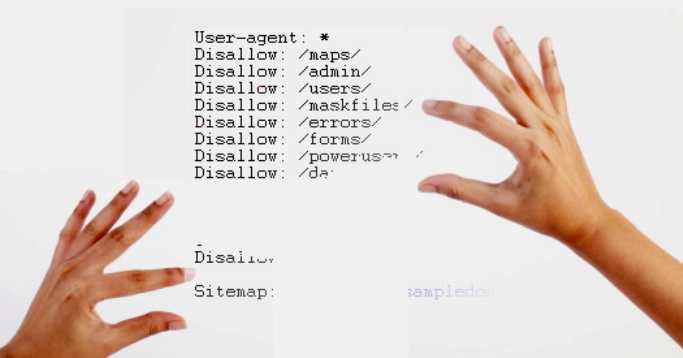

Как правило, владельцы сайтов не хотят отображать в поисковых системах: административные страницы, бэкэнд-порталы, категории и теги, а также другие информационные страницы. Файл robots.txt также можно использовать, чтобы поисковики не проверяли страницы. Короче говоря, robots.txt сообщает веб-сканерам, что делать.

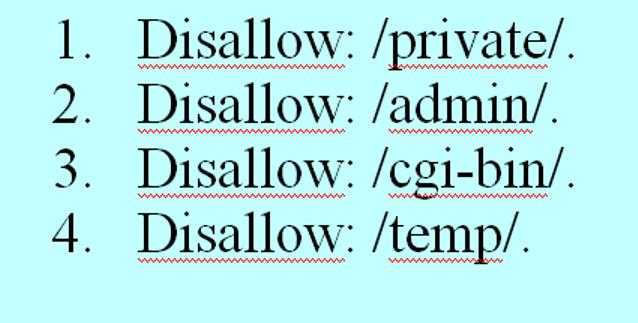

Запрет страниц

Это основная часть файла исключения роботов. С помощью простого объявления пользователь указывает боту или группе ботов, чтобы они не сканировали определенные страницы. Синтаксис прост, например, для запрета доступа ко всему в директории «admin» сайта пишется: Disallow: /admin. Эта строка не позволит ботам сканировать сайты yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html и все остальное, попадающее под каталог администратора.

Чтобы запретить одну страницу, просто указывают ее в строке запрета: Disallow: /public/exception.html. Теперь страница «исключение» не будет перенесена, но все остальное в «общедоступной» папке будет.

Чтобы включить несколько страниц, просто перечисляют их:

Эти четыре строки правильного Robots txt для symphony будут применяться к любому пользовательскому агенту, указанному в верхней части раздела # robots.txt для https://www.symphonyspace.org/.

Карта сайта: https://www.symphonyspace.org/sitemaps/1/sitemap.xml.

Другие команды: # live - не разрешать веб-сканерам индексировать cpresources/ или поставщика/.

Пользовательский агент: * Disallow: / cpresources /.

Запретить: / vendor / Disallow: /.env.

Настройка стандартов

Пользователь может указать определенные страницы для разных ботов, объединив предыдущие два элемента, вот как это выглядит. Пример правильного Robots txt для всех поисковиков представлен ниже.

Секции «admin» и «private» будут невидимы для Google и Bing, но Google все же увидит «секретный» каталог, в то время как Bing этого не сделает. Можно указать общие правила для всех ботов, используя пользовательский агент asterisk, а затем дать конкретные инструкции ботам в последующих разделах. Со знанием выше пользователь может написать пример правильного Robots txt для всех поисковиков. Просто запустить свой любимый текстовый редактор и сообщить ботам, что их не приветствуют в определенных частях сайта.

Советы по повышению производительности сервера

SublimeText - это универсальный текстовый редактор и золотой стандарт для многих программистов. Его программные советы основаны на эффективном кодировании, кроме того. пользователи ценят в программе наличие быстрых клавиш. Если пользователь хочет увидеть пример файла robots.txt, нужно перейти на любой сайт и добавить «/robots.txt» в конец. Вот часть файла robots.txt GiantBicycles.

Программа обеспечивает создание страниц, которые пользователи не хотят показывать в поисковиках. И также имеет несколько эксклюзивных вещей, о которых мало кому известно. Например, если файл robots.txt сообщает ботам, куда не нужно идти, файл Sitemap делает все наоборот и помогает им находить то, что они ищут, и хотя поисковики, вероятно, уже знают, где расположена карта сайта, не мешает им.

Существует два типа файлов: HTML страница или XML файл. HTML страница - это та, которая показывает посетителям все имеющиеся страницы на вебсайте. В собственном robots.txt он выглядит так: Sitemap: //www.makeuseof.com/sitemap_index.xml. Если сайт не индексируется поисковыми системами, хотя он несколько раз сканировался веб-роботами, нужно убедиться, что файл присутствует и что его разрешения установлены правильно.

По умолчанию это будет происходить со всеми установками SeoToaster, но в случае необходимости можно сбросить его следующим образом: File robots.txt – 644. В зависимости от PHP-сервера, если это не работает для пользователя, рекомендуется попробовать следующее: File robots.txt – 666.

Установка задержки сканирования

Директива о задержке обхода сообщает определенным поисковикам, как часто они могут индексировать страницу на сайте. Она измеряется в секундах, хотя некоторые поисковые системы интерпретируют ее несколько иначе. Некоторые видят задержку обхода 5, когда говорят им подождать пять секунд после каждого сканирования, чтобы начать следующее.

Другие интерпретируют это, как инструкцию сканировать только одну страницу каждые пять секунд. Робот не может сканировать быстрее, чтобы сохранить пропускную способность сервера. Если сервер должен соответствовать трафику, он может установить задержку обхода. В общем, в большинстве случаев, пользователям не нужно беспокоиться об этом. Вот так устанавливается задержка обхода восьми секунд - Crawl-delay: 8.

Вам будет интересно:Как раскрутить доску объявлений с нуля: полезные советы

Вам будет интересно:Как раскрутить доску объявлений с нуля: полезные советы

Но не все поисковые системы будут подчиняться этой директиве, поэтому при запрете страниц, можно установить различные задержки сканирования для определенных поисковых систем. После того, как все инструкции в файле настроены, можно загрузить его на сайт, предварительно убедиться, что это простой текстовый файл и имеет имя robots.txt и его можно найти по адресу yoursite.com/robots.txt.

Лучший бот WordPress

На сайте WordPress есть некоторые файлы и каталоги, которые необходимо каждый раз блокировать. Каталоги, которые пользователи должны запретить - это каталог cgi-bin и стандартные каталоги WP. Некоторые серверы не разрешают доступ к каталогу cgi-bin, но пользователи должны включить его в директиву disallow, перед тем как правильно настроить Robots txt WordPress

Стандартными каталогами WordPress, которые должны заблокировать, являются wp-admin, wp-content, wp-includes. В этих каталогах нет данных, которые изначально полезны для поисковых систем, но существует исключение, т. е. в каталоге wp-content существует подкаталог с именем uploads. Этот подкаталог должен быть разрешен в файле robot.txt, поскольку он включает все, что загружается, используя функцию загрузки WP media. WordPress использует теги или категории для структурирования контента.

Если категории используются, то для того, чтобы сделать правильный Robots txt для Wordpress, как указано производителем программы, необходимо заблокировать архивы тегов из поиска. Сначала проверяют базу, зайдя в панель «Администрирование»> «Настройки»> «Постоянная ссылка».

По умолчанию базой является тег, если поле пустое: Disallow: / tag /. Если используется категория, то необходимо заблокировать категорию в файле robot.txt: Disallow: / category /. По умолчанию базой является тег, если поле пустое: Disallow: / tag /. Если используется категорию, то необходимо заблокировать категорию в файле robot.txt: Disallow: / category /.

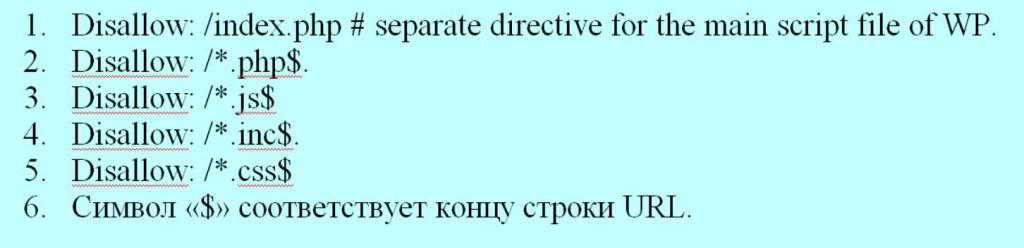

Файлы, используемые в основном для отображения содержимого, они заблокируются правильным файлом Robots txt для Wordpress:

Основная настройка Joomla

Как только пользователь установил Joomla, нужно просмотреть правильную настройку Robots txt Joomla в глобальной конфигурации, которая расположена на панели управления. Некоторые настройки здесь очень важны для SEO. Сначала находят имя сайта и убеждаются, что используется короткое имя сайта. Затем находят группу настроек справа от того же экрана, который называется настройками SEO. Тот, который определенно придется изменить, является вторым: использовать URL-адрес перезаписи.

Это звучит сложно, но в основном это помогает Joomla создавать более чистые URL-адреса. Наиболее заметно, если удалить строку index.php из URL-адресов. Если изменить ее позже, URL-адреса изменятся, и Google это не понравится. Однако при изменении этого параметра необходимо сделать одновременно несколько шагов для создания правильного robots txt для Joomla:

Робот в облаке MODX

Ранее MODX Cloud предоставлял пользователям возможность контролировать поведение разрешающего файла robots.txt для обслуживания на основе переключения в панели мониторинга. Хотя это было полезно, можно было случайно разрешить индексирование на сайтах staging/dev, переключив опцию в Dashboard. Аналогичным образом можно было легко запретить индексирование на производственной площадке.

Сегодня сервис полагает присутствие файлов robots.txt в файловой системе со следующим исключением: любой домен, который заканчивается, modxcloud.com будет служить Disallow: /директивой для всех пользовательских агентов, независимо от наличия или отсутствия файла. Для производственных площадок, которые получают реальный трафик посетителей, нужно будет использовать собственный домен, если пользователь хочет проиндексировать свой сайт.

Некоторые организации используют правильный Robots txt для modx для запуска нескольких вебсайтов из одной установки с использованием Contexts. Случаем, в котором это может быть применено, будет публичный маркетинговый сайт в сочетании с микро сайтами целевой страницы и, возможно, непубличной интрасети.

Традиционно это было сложно сделать для многопользовательских установок, поскольку они разделяют один и тот же корень сети. В MODX Cloud выполнить это легко. Просто загружают дополнительный файл на веб-сайт, названный robots-intranet.example.com.txt следующим контентом, и он заблокирует индексирование с помощью хорошо работающих роботов, а все остальные имена хостов возвратятся к стандартным файлам, если не существует других конкретных именных узлов.

Robots.txt является важным файлом, который помогает пользователю ссылаться на сайт в Google, основных поисковых системах и других вебсайтах. Расположенный в корне веб-сервера - файл инструктирует веб-роботов для сканирования сайта, устанавливает какие папки он должен или не должен индексировать, с помощью набора инструкций, называемых Протоколом исключения роботов. Пример правильного Robots txt для всех поисковиков obots.txt особенно просто выполняется с помощью SeoToaster. Для него создано специальное меню в панели управления, поэтому боту никогда не придется перенапрягаться для получения доступа.